Comprender cómo funcionan las 4 fases de los motores de búsqueda para clasificar el contenido SEO es de suma importancia para profesionales de SEO.

Qué es el SEO

SEO significa optimización de motores de búsqueda, que es un conjunto de prácticas diseñadas para mejorar la apariencia y el posicionamiento de las páginas web en los resultados de búsqueda orgánicos. Debido a que la búsqueda orgánica es la forma más prominente para que las personas descubran y accedan al contenido en línea. Una buena estrategia de SEO es esencial para mejorar la calidad y la cantidad de tráfico a su sitio web.

Cómo funcionan las fases del SEO

Los motores de búsqueda como Google y Bing utilizan rastreadores, a veces también llamados bots o arañas. Esto para recopilar información sobre todo el contenido que pueden encontrar en Internet. El rastreador comienza desde una página web conocida y sigue los enlaces internos a las páginas dentro de ese sitio. Así como los enlaces externos a las páginas de otros sitios. El contenido de esas páginas, más el contexto de los enlaces que siguió, ayudan al rastreador a comprender de qué se trata cada página.

Cuando un usuario escribe una consulta en el cuadro de búsqueda, el motor de búsqueda utiliza algoritmos para extraer lo que cree que es la lista de resultados más precisa y útil para esa consulta. Estos resultados orgánicos pueden incluir páginas web llenas de texto, artículos de noticias, imágenes, videos, listados de negocios locales. También, otros tipos de contenido más especializados.

Por qué es importante conocer la diferencia en las fases del SEO

En un caso de infracción de marca registrada en el que el testigo opuesto se equivocó en las etapas de búsqueda. Dos pequeñas empresas argumentaron que cada una tenía derecho a utilizar marcas similares. Un argumento que emplearon fue que la otra marca llegó a utilizar un SEO inadecuado y hostil para superar el sitio web del demandante.

Pero cometieron errores críticos al describir los procesos de Google para respaldar su argumento. Ellos afirmaron que la indexación era el rastreo web. También que los robots de búsqueda instruyen al motor de búsqueda sobre cómo clasificar las páginas en los resultados de búsqueda. Finalmente que los robots de búsqueda también podrían ser «entrenados» para indexar páginas para ciertas palabras clave.

Así que, como defensa de litigio se pudo excluir los hallazgos de un experto que testifica. Ya que, esto sucede porque el experto no tiene las calificaciones necesarias para ser tomado en cuenta. Como en este caso el experto claramente no estaba calificado para testificar sobre asuntos de SEO en absoluto, se presentó como evidencia la forma en que Google actúa en la búsqueda.

Muchos no saben cómo se dan las fases de búsqueda en SEO

En definitiva, el experto no calificado cometió muchos errores fundamentales y obvios al presentar información al tribunal. Todo ello, porque no tenía una comprensión correcta de las fases de búsqueda utilizadas por los principales motores de búsqueda. Así que, no conocer cómo funciona este aspecto, podría terminar perjudicando totalmente el SEO de una marca.

Hay bastantes profesionales de Marketing Digital que también combinan las etapas de los procesos de los motores de búsqueda. Esto conduce a diagnósticos incorrectos de bajo rendimiento en los SERP. De hecho, muchos piensan que Google los penaliza cuando ven que no aparecen en los resultados de búsqueda. Pero, en realidad han perdido una configuración clave en sus servidores web. Lo que hacía que el contenido de su sitio fuera inaccesible para Google.

Las penalizaciones automáticas podrían categorizarse como parte de la fase de clasificación de Google, algo que los expertos de SEO saben. En realidad, estos sitios web tenían problemas en las etapas de rastreo y representación. Esto hacía que la indexación y la clasificación fueran problemáticas. Por lo que, cuando no hay notificaciones en Google Search Console de una acción manual. Primero se debe centrar en problemas comunes en cada una de las cuatro etapas que determinan cómo funciona la búsqueda.

No es solo semántica

Se tiene que comprender las diferencias entre gatear, renderizar, indexar y clasificar. Algunos profesionales consideran que esto es solamente semántica innecesaria por parte de los SEO. Hasta cierto punto, algunos veteranos de SEO pueden estar un poco confundidos sobre los significados de estos términos de las fases . Esto puede suceder en todas las disciplinas cuando aquellos inmersos en el conocimiento están mezclando jerga con una comprensión compartida de a qué se refieren. No hay nada intrínsecamente malo en eso.

También hay una tendencia a antropomorfizar los motores de búsqueda y sus procesos. Ya que, al interpretar las cosas describiéndolas con características familiares facilita la comprensión. Tampoco hay nada de malo en esto. Pero, esta imprecisión cuando se habla de procesos técnicos puede ser confusa. Y se hace más desafiante para aquellos que intentan aprender sobre la disciplina de SEO. Uno puede usar los términos de manera casual e imprecisa sólo hasta cierto punto. Siempre es mejor conocer y comprender las definiciones precisas de las fases de búsqueda de motores de búsqueda, para un experto en SEO.

4 fases de búsqueda que un experto SEO debe saber

En realidad, hay muchos procesos diferentes involucrados para llevar el contenido de la web a los resultados de búsqueda. De alguna manera, puede ser una simplificación excesiva decir que solo hay un puñado de etapas discretas para que esto suceda. Cada una de las cuatro etapas, tiene varios subprocesos que pueden ocurrir dentro de ellas. Incluso, hay procesos significativos que pueden ser asincrónicos a estos, tales como:

- Tipos de policía de spam.

- Incorporación de elementos en el Knowledge Graph y actualización de paneles de conocimiento con la información.

- Procesamiento de reconocimiento óptico de caracteres en imágenes.

- Procesamiento de audio a texto en archivos de audio y vídeo.

- Evaluación y aplicación de datos de PageSpeed.

Lo que sigue son las fases principales de búsqueda requeridas, que todo experto SEO debe saber, para que las páginas web aparezcan en los resultados de búsqueda.

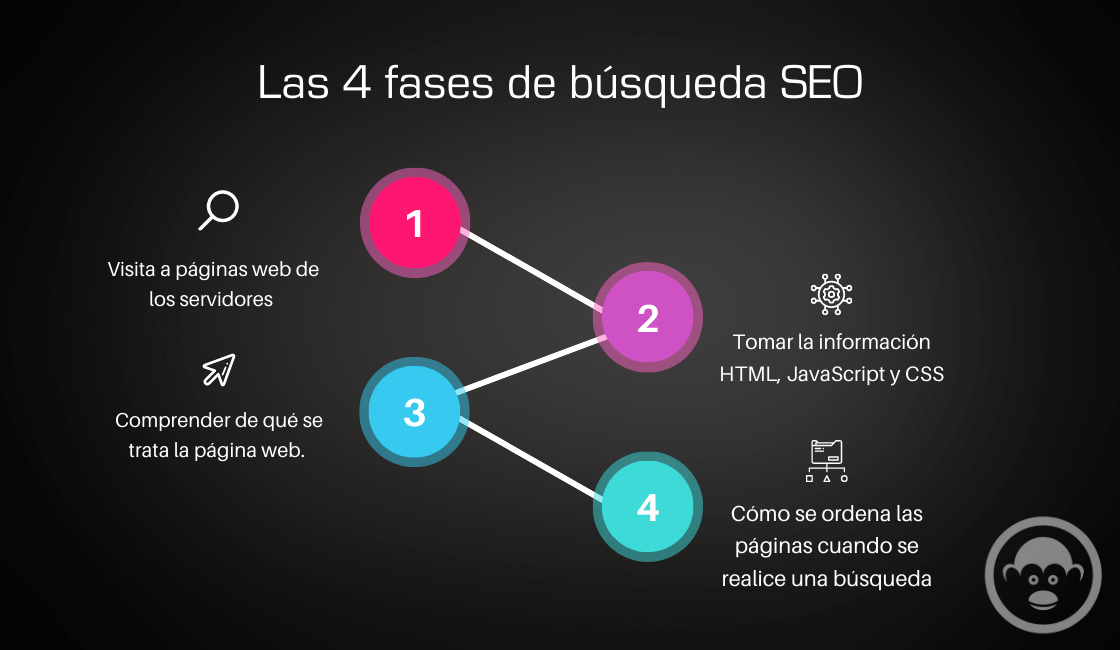

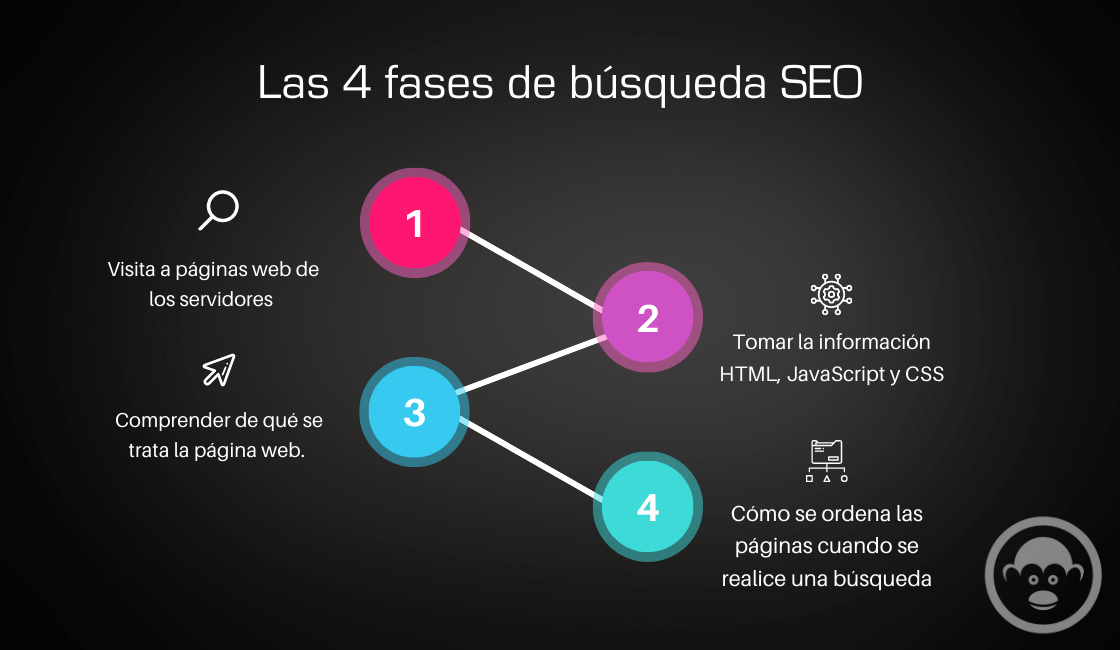

Una de las fases de búsqueda SEO: Rastreo

El rastreo se produce cuando un motor de búsqueda solicita páginas web de los servidores de los sitios web. Es como imaginar que, Google y Microsoft Bing están sentados en una computadora, escribiendo o haciendo clic en un enlace a una página web en la ventana de su navegador. Por lo tanto, las máquinas de los motores de búsqueda visitan páginas web de manera similar a como lo hace usted. Cada vez que el motor de búsqueda visita una página web, recopila una copia de esa página y anota todos los enlaces que se encuentran en esa página. Después de que el motor de búsqueda recopile esa página web, visitará el siguiente enlace en su lista de enlaces que aún no se han visitado. Esto se conoce como «rastreo» o «araña», lo cual es adecuado. Ya que, la web es metafóricamente una red virtual gigante de enlaces interconectados.

Los programas de recopilación de datos utilizados por los motores de búsqueda se llaman «arañas», «bots» o «rastreadores». El programa de rastreo principal de Google es «Googlebot», mientras que Microsoft Bing tiene «Bingbot». Cada uno tiene otros bots especializados para visitar anuncios. Es decir, GoogleAdsBot y AdIdxBot), páginas móviles y más. Esta etapa del procesamiento de páginas web de los motores de búsqueda parece sencilla, pero hay mucha complejidad en lo que sucede, solo en esta etapa.

Por qué es complicado el rastreo

Hay muchos sistemas de servidores web, ejecutando diferentes sistemas operativos de diferentes versiones, junto con diferentes sistemas de administración de contenido (WordPress, Wix, Squarespace). Y también, las personalizaciones únicas de cada sitio web. Muchos problemas pueden evitar que los rastreadores de los motores de búsqueda rastreen las páginas. Lo cual es una excelente razón para estudiar los detalles involucrados en las fases de búsqueda SEO.

Primero, el motor de búsqueda debe encontrar un enlace a la página en algún momento antes de poder solicitar la página y visitarla. Bajo ciertas configuraciones, se sabe que los motores de búsqueda sospechan que podría haber otros enlaces no revelados. Como un paso adelante en la jerarquía de enlaces a nivel de subdirectorio. A través de algunos formularios de búsqueda internos limitados del sitio web.

Descubrir enlaces

Los motores de búsqueda pueden descubrir los enlaces de las páginas web a través de los siguientes métodos:

- Cuando un operador de sitio web envía el enlace directamente o divulga un mapa del sitio al motor de búsqueda.

- Cuando otros sitios web enlazan a la página.

- A través de enlaces a la página desde dentro de su propio sitio web, asumiendo que el sitio web ya tiene algunas páginas indexadas.

- Publicaciones en redes sociales.

- Enlaces que se encuentran en los documentos.

- URL encontradas en texto escrito y no hipervinculadas.

- A través de los metadatos de varios tipos de archivos.

En algunos casos, un sitio web indicará a los motores de búsqueda que no rastreen una o más páginas web a través de su archivo .txt robots. Este se encuentra en el nivel base del dominio y el servidor web. Los archivos .txt robots pueden contener múltiples directivas dentro de ellos. Instruyen a los motores de búsqueda cuando el sitio web no permite el rastreo de páginas específicas, subdirectorios o todo el sitio web. Por esto, es una de las fases más complicadas de búsqueda SEO.

Instruir a los motores de búsqueda para que no rastreen una página o sección de un sitio web no significa que esas páginas no puedan aparecer en los resultados de búsqueda. Evitar que sean rastreados de esta manera puede afectar gravemente su capacidad para clasificar bien sus palabras clave. En otros casos, los motores de búsqueda pueden tener dificultades para rastrear un sitio web si el sitio bloquea automáticamente los bots.

Dificultades para rastrear un sitio web

- El bot está solicitando más páginas dentro de un período de tiempo que un humano.

- El bot solicita varias páginas simultáneamente.

- La dirección IP del servidor de un bot está geolocalizada dentro de una zona para la que se ha configurado el sitio web.

- Las solicitudes del bot y / o las solicitudes de páginas de otros usuarios abruman los recursos del servidor. Lo que hace que el servicio de páginas se ralentice o se produzca un error.

Sin embargo, los bots de los motores de búsqueda están programados para cambiar automáticamente las tasas de retraso entre las solicitudes. Esto cuando detectan que el servidor está luchando para mantenerse al día con la demanda. Para sitios web más grandes y sitios web con contenido que cambia con frecuencia en sus páginas, el «presupuesto de rastreo» puede convertirse en un factor. Ya que, los robots de búsqueda se moverán para rastrear todas las páginas.

Esencialmente, la web es algo así como un espacio infinito de páginas web con una frecuencia de actualización variable. Es posible que los motores de búsqueda no visiten todas las páginas que existen. Los sitios web con un gran número de páginas, o que responden más lentamente, pueden agotar su presupuesto de rastreo disponible. Antes de que se rastreen todas sus páginas si tienen un peso de clasificación relativamente más bajo en comparación con otros sitios web.

Es útil mencionar que los motores de búsqueda también solicitan todos los archivos que entran en la composición de la página web, como imágenes, CSS y JavaScript. Al igual que con la página web en sí, si los recursos adicionales que contribuyen a componer la página web son inaccesibles para el motor de búsqueda. Esto puede afectar la forma en que el motor de búsqueda interpreta la página web.

Una de las fases de búsqueda SEO: Renderización

Cuando el motor de búsqueda rastrea una página web, entonces «renderizará» la página. Esto implica tomar la información HTML, JavaScript y hoja de estilo en cascada (CSS) para generar cómo aparecerá la página para los usuarios de escritorio y / o móviles. Es importante para que el motor de búsqueda pueda comprender cómo se muestra el contenido de la página web en contexto. El procesamiento de JavaScript ayuda a garantizar que puedan tener todo el contenido que un usuario humano vería al visitar la página.

Los motores de búsqueda clasifican el paso de representación como un subproceso dentro de las fases de rastreo SEO. Es un paso separado en el proceso porque buscar una página web y luego analizar el contenido para comprender cómo aparecería compuesto en un navegador. Son dos procesos distintos. Google utiliza el mismo motor de renderizado que se emplea en el navegador Google Chrome, llamado «Rendertron». Este se basa en el sistema de navegador de código abierto Chromium.

Bingbot utiliza Microsoft Edge como motor para ejecutar JavaScript y representar páginas web. Ahora también se basa en el navegador basado en Chromium. Por lo que, representa las páginas web de manera muy equivalente a la forma en que lo hace Googlebot.

Google almacena copias de las páginas en su repositorio en un formato comprimido. Parece que Microsoft Bing también lo va a hacer. Algunos motores de búsqueda pueden almacenar una versión abreviada de las páginas web en términos de solo el texto visible, despojado de todo el formato. La representación se convierte principalmente en un problema en SEO para páginas que tienen partes clave de contenido que dependen de JavaScript / AJAX.

Google y Bing en las fases de búsqueda SEO, Renderización

Tanto Google como Microsoft Bing ejecutan JavaScript para ver todo el contenido de la página. También, las construcciones de JavaScript más complejas pueden ser un desafío para el funcionamiento de los motores de búsqueda. Hay muchas páginas web construidas con JavaScript que son esencialmente invisibles para los motores de búsqueda. Lo que resulta en páginas web muy poco óptimas que no podrían clasificarse para sus términos de búsqueda.

También hay casos en los que las páginas de categorías de desplazamiento infinito en sitios web de comercio electrónico no funcionaron bien en los motores de búsqueda. Porque el motor de búsqueda no pudo ver tantos enlaces de los productos. Otras condiciones también pueden interferir con la representación. Por ejemplo, cuando hay uno o más archivos JaveScript o CSS inaccesibles para los bots de los motores de búsqueda. Debido a que están en subdirectorios no permitidos por robots.txt, será imposible procesar completamente la página.

Googlebot y Bingbot en gran medida no indexarán las páginas que requieren cookies. Las páginas que entregan condicionalmente algunos elementos clave basados en cookies también pueden no renderizarse completa o correctamente.

Una de las fases de búsqueda SEO: Indexación

Una vez que una página es rastreada y renderizada, los motores de búsqueda procesan aún más la página. Esto para determinar si se almacenará en el índice o no. También, para comprender de qué se trata la página. El índice del motor de búsqueda es funcionalmente similar a un índice de palabras que se encuentra al final de un libro.

El índice de un libro enumerará todas las palabras y temas importantes que se encuentran en el libro, enumerando cada palabra alfabéticamente. Junto con una lista de los números de página donde se encontrarán las palabras / temas. Un índice de motor de búsqueda contiene muchas palabras clave y secuencias de palabras clave. Estas están asociadas con una lista de todas las páginas web donde se encuentran las palabras clave.

El índice tiene cierta semejanza conceptual con una tabla de búsqueda de base de datos, que puede haber sido originalmente la estructura utilizada para los motores de búsqueda. Pero es probable que los principales motores de búsqueda ahora usen algo un par de generaciones más sofisticado para lograr el propósito de buscar una palabra clave. También para devolver todas las URL relevantes para la palabra en las fases de búsqueda SEO.

Buscar todas las páginas asociadas con una palabra clave

El uso de la funcionalidad para buscar todas las páginas asociadas con una palabra clave es una arquitectura que ahorra tiempo. Ya que, requeriría cantidades de tiempo excesivamente inviables para buscar una palabra clave en todas las páginas web en tiempo real, cada vez que alguien la busca.

No todas las páginas rastreadas se mantendrán en el índice de búsqueda, por varias razones. Por ejemplo, si una página incluye una metaetiqueta robots con una directiva «noindex», indica al motor de búsqueda que no incluya la página en el índice. Del mismo modo, una página web puede incluir una etiqueta X-Robots en su encabezado HTTP que indica a los motores de búsqueda que no indexen la página.

En otros casos, la etiqueta canónica de una página web puede indicar a un motor de búsqueda que una página diferente de la actual debe considerarse la versión principal de la página. Lo que resulta en otras versiones no canónicas de la página que se eliminarán del índice. En las fases de la búsqueda de Google es siempre importante tener en cuenta este aspecto. Google también indica que las páginas web no pueden mantenerse en el índice si son de baja calidad. Por ejemplo, páginas de contenido duplicado, páginas de contenido delgado y páginas que contienen todo o demasiado contenido irrelevante.

También los sitios web con PageRank colectivo insuficiente pueden no tener todas sus páginas web indexadas. Lo que sugiere que los sitios web más grandes con enlaces externos insuficientes pueden no indexarse a fondo. Un presupuesto de rastreo insuficiente también puede hacer que un sitio web no tenga todas sus páginas indexadas.

Un componente importante del SEO es diagnosticar y corregir cuando las páginas no se indexan. Debido a esto, es una buena idea estudiar a fondo todos los diversos problemas que pueden afectar la indexación de las páginas web.

Una de las fases de búsqueda SEO: Clasificación

La clasificación de las páginas web es la etapa del procesamiento de los motores de búsqueda en la que probablemente se centre más. Una vez que un motor de búsqueda tiene una lista de todas las páginas web asociadas con una palabra clave o frase de palabra clave en particular. Este debe determinar cómo ordenará esas páginas cuando se realice una búsqueda de la palabra clave.

Si trabaja como consultor SEO, es probable que ya esté bastante familiarizado con parte de lo que implica el proceso de clasificación. El proceso de clasificación del motor de búsqueda también se conoce como un «algoritmo». La complejidad involucrada con la etapa de clasificación de la búsqueda es tan grande que solo merece múltiples artículos y libros para describir.

Hay muchos criterios que pueden afectar el rango de una página web en los resultados de búsqueda. Google dice que hay más de 200 factores de clasificación utilizados por su algoritmo. Dentro de muchos de esos factores, también puede haber hasta 50 «vectores», cosas que pueden influir en el impacto de una sola señal de clasificación en las clasificaciones. Por ello, todas las fases de búsqueda SEO son tan importantes.

Podría interesarte: Conviértete en un experto con el Curso de SEO Posicionamiento en Buscadores

PageRank, cómo afecta a las fases de búsqueda Seo

PageRank es la primera versión de Google de su algoritmo de clasificación inventado en 1996. Se construyó a partir de un concepto de que los enlaces a una página web, y la importancia relativa de las fuentes de los enlaces que apuntan a esa página web. Podría calcularse para determinar la fuerza de clasificación de la página en relación con todas las demás páginas. Una metáfora de esto es que los enlaces se tratan de alguna manera como votos. Las páginas con la mayoría de los votos ganarán en la clasificación más alta que otras páginas con menos enlaces/votos.

Es 2022 y gran parte del ADN del antiguo algoritmo PageRank todavía está incrustado en el algoritmo de clasificación de Google. Ese algoritmo de análisis de enlaces también influyó en muchos otros motores de búsqueda que desarrollaron tipos similares de métodos. El antiguo método del algoritmo de Google tenía que procesar los enlaces de la web de forma iterativa. Se pasaba el valor de PageRank entre las páginas docenas de veces antes de que se completara el proceso de clasificación. Esta secuencia de cálculo iterativo en muchos millones de páginas podría tardar casi un mes en completarse. Hoy en día, todos los días se introducen nuevos enlaces de páginas, y Google calcula las clasificaciones en una especie de método de goteo. Lo que permite que las páginas y los cambios se tengan en cuenta mucho más rápidamente sin necesidad de un proceso de cálculo de enlaces de un mes de duración.

Además, los enlaces se evalúan de una manera sofisticada: Revocando o reduciendo el poder de clasificación de los enlaces pagados, los enlaces comercializados. También, los enlaces spameados, los enlaces no respaldados editorialmente y más.

Categorías que influyen en la clasificación

Las amplias categorías de factores más allá de los enlaces también influyen en las clasificaciones, incluyen:

- Experiencia, autoridad y confiabilidad.

- Calidad.

- Ubicación/Proximidad.

- Historial de búsqueda personal.

- Cifrado vs. no cifrado (el uso de Secure Socket Layer o SSL) para entregar páginas web, indicado por el prefijo de URL «HTTPS».

- Compatibilidad con dispositivos móviles.

- Velocidad de la página.

Conclusión sobre: Las 4 fases de búsqueda que todos los SEO necesitan saber

Comprender las fases clave de la búsqueda es un elemento fundamental para convertirse en un consultor profesional en la industria de SEO. Ya que, no contratar a un candidato solo porque no conocen las diferencias entre estas fases es ir demasiado lejos. Sobre todo, porque es importante conocer las distinciones entre estos procesos. No conocer o tener una comprensión borrosa de tales términos es un factor decisivo. Los profesionales de SEO pueden tener diversos niveles de experiencia. Así que, lo importante es que sean lo suficientemente entrenables como para aprender y alcanzar un nivel fundamental de comprensión.

Te puede interesar: